Giovedì Apple ha annunciato che con i prossimi aggiornamenti dei suoi sistemi operativi introdurrà un meccanismo per individuare immagini pedopornografiche nei dispositivi mobili venduti dall’azienda negli Stati Uniti. Un’innovazione di questo genere era richiesta da tempo dai gruppi che si occupano di sicurezza dei bambini e dalle agenzie investigative americane, ma ha preoccupato molti esperti di privacy online che temono che in futuro sistemi simili possano essere usati anche per cercare altri tipi di immagini e dati personali, e magari da governi autoritari per spiare i propri cittadini.

Il sistema per rilevare le immagini pedopornografiche – spiegato in breve qui, e più nel dettaglio qui– analizzerà tutte le immagini che i possessori di dispositivi iOS o iPadOS caricheranno su iCloud Photos, uno dei servizi di archiviazione online di Apple. Confronterà le immagini con database di fotografie pedopornografiche forniti da organizzazioni che si occupano di sicurezza dei bambini tra cui il Centro nazionale per i bambini scomparsi e sfruttati (NCMEC), un ente istituito dal Congresso e finanziato dal dipartimento di Giustizia americano che collabora con le forze dell’ordine.

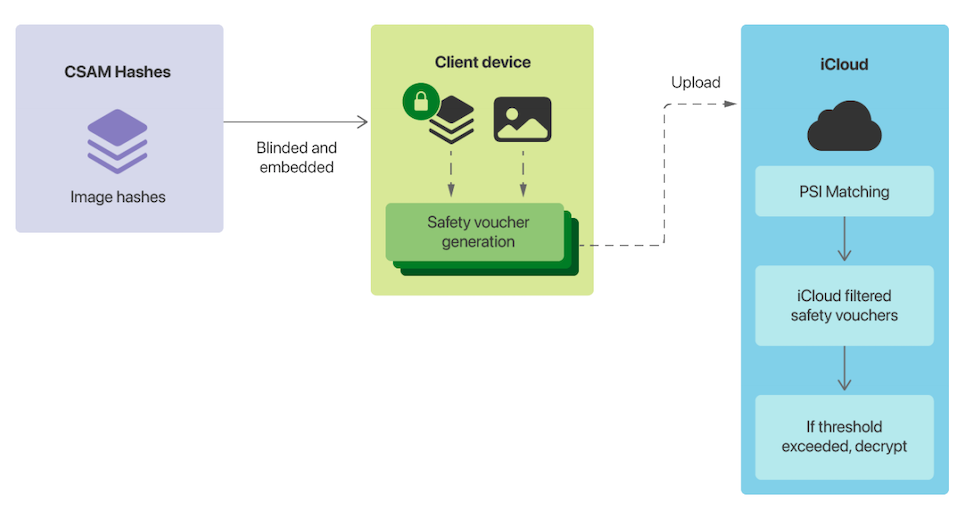

L’analisi delle immagini comunque non avverrà online, come già viene fatto quando una fotografia viene spedita via email o caricata su un social network, ma direttamente sui dispositivi. Il confronto sarà possibile grazie a un doppio processo crittografico che trasforma il database di immagini pedopornografiche note in stringhe di testo. La sequenza di stringhe sarà presente all’interno dei nuovi sistemi operativi, accuratamente protetta (cioè non succederà che un utente possa accedere al database dai propri dispositivi), e verrà usata per analizzare le caratteristiche delle immagini caricate su iCloud Photos.

Le immagini che risulteranno simili a quelle del database saranno caricate insieme a una specie di etichetta nascosta. Se un account di iCloud Photos supererà una certa soglia di probabili contenuti pedopornografici, «fissata in modo da garantire un livello di accuratezza estremamente alto» ed evitare segnalazioni erronee (è previsto un errore su mille miliardi di utenti all’anno), Apple riceverà una segnalazione: ognuna sarà decrittata e rivista manualmente, e se sarà confermata la natura pedopornografica verrà inoltrata al NCMEC. Contestualmente l’account dell’utente segnalato sarà sospeso. Prima che una segnalazione sia mandata alle forze dell’ordine sarà rivista anche dal NCMEC.

Apple ha presentato l’innovazione dicendo che protegge in vari modi la privacy di chi usa i suoi dispositivi, principalmente perché l’azienda «non ha accesso in alcun modo alle immagini che non risultano simili a quelle del database pedopornografico» e «non può accedere ai metadati delle immagini segnalate finché non viene raggiunta la soglia per un account». Nonostante queste rassicurazioni tra gli esperti di privacy ci sono comunque perplessità. «A prescindere dai suoi piani a lungo termine, Apple ha mandato un messaggio molto chiaro», ha detto Matthew Green, un ricercatore di sicurezza informatica della Johns Hopkins University: «I governi chiederanno sistemi simili a tutte le altre aziende». La preoccupazione condivisa è che sistemi simili a quello di Apple possano essere usati per altri scopi.

Parlando con il Financial Times, un altro ricercatore di sicurezza informatica, l’ex dipendente di Facebook e Deliveroo Alec Muffett, ha detto la novità di Apple è «un enorme passo indietro per la privacy individuale» e che «Apple sta facendo indietreggiare la privacy per rendere possibile 1984».